Welcome back to the Abstract! Here are the studies this week that boiled my blood, warmed my heart, and got permanently inked into my memory.

First, a new look at some very old tattoos. Then: a posthumous discovery from a beloved defunct telescope, an update on lava planets, the adventures of translocated mole rats, and some provocative style tips from chimpanzees.

Ink of ages

Some 2,300 years ago, a woman from the nomadic Pazyryk culture of Siberia was inked with elaborate tattoos, including dynamic animal fights. Her body and its mesmerizing displays have survived to this day, along with many other “Pazyryk ice mummies” that were immaculately preserved in permafrost tombs.

Now, scientists have imaged the woman’s epic epidermis with high-resolution techniques that expose hidden details of her tattoos, yielding new insights about the artists and tools that made them.

“While the images on the hands are mostly simple designs, the most elaborate of which is a rooster on the left thumb, the forearms display some of the most complex Pazyryk tattoos currently identified,” said researchers led by Gino Caspari of the Max Planck Institute of Geoanthropology.

Photogrammetrically created 3D model of the mummy, showing: A) texture derived from visible-spectrum photographs; and B) texture derived from near-infrared photography. Credit: M. Vavulin

The results revealed that the middle-aged woman was tattooed with at least two different instruments: a multipoint tool that provided a uniform line thickness, as well as a finer tool with a single point. The pigment was probably crafted from soot or burnt plants, but the nature of the “needles” remains unclear (they may have been plant thorns, for instance). The new images exposed the superior quality in the scene on her right forearm compared to the left, which suggests that at least two artists worked on the decorations over multiple sessions.

“The right-forearm tattoo likely required at least two sessions to complete, beginning with the ungulate [stag] positioned at the wrist,” the researchers said. “This clever placement utilizes the contours of the wrist to enhance the ungulate’s form, allowing the tattoo to flow across the arm.”

“The right-forearm tattoo also features techniques that are challenging from the tattooist’s perspective” yet “the linework is clear and consistent, with nearly double the amount of outlining present on the left forearm,” they added. “Taken as a whole, this evidence suggests that the left forearm tattoo was created by an artist with less experience or skill.”

A figure depicting the tattoos and placement on the body. Image: Svetlana Pankova

Tattoos represent a diversity of meanings and practices across regions and time, and it’s important not to color bodies of the past with our present biases. While we may never know exactly what these dramatic scenes meant to the Pazyryk culture, it is amazing that we can behold them in such fantastic detail thousands of years after this woman, and her tattooists, lived and died in the Altai Mountains.

“Modifications to soft tissue, including tattooing, present a temporal paradox as they are simultaneously permanent over the lifetime of the marked individual, yet transitory from an archaeological perspective,” said Caspari and his colleagues. “The interpretation of tattoos in prehistoric contexts necessarily remains speculative and may never reach the intricate richness of meaning with which the images and practices were originally associated.”

If this story piques your interest in the ancient artistry of Altai Mountain cultures (understandable!), check another recent study about the stylistic shifts in the region’s rock art depictions of elk over thousands of years.

In other news…

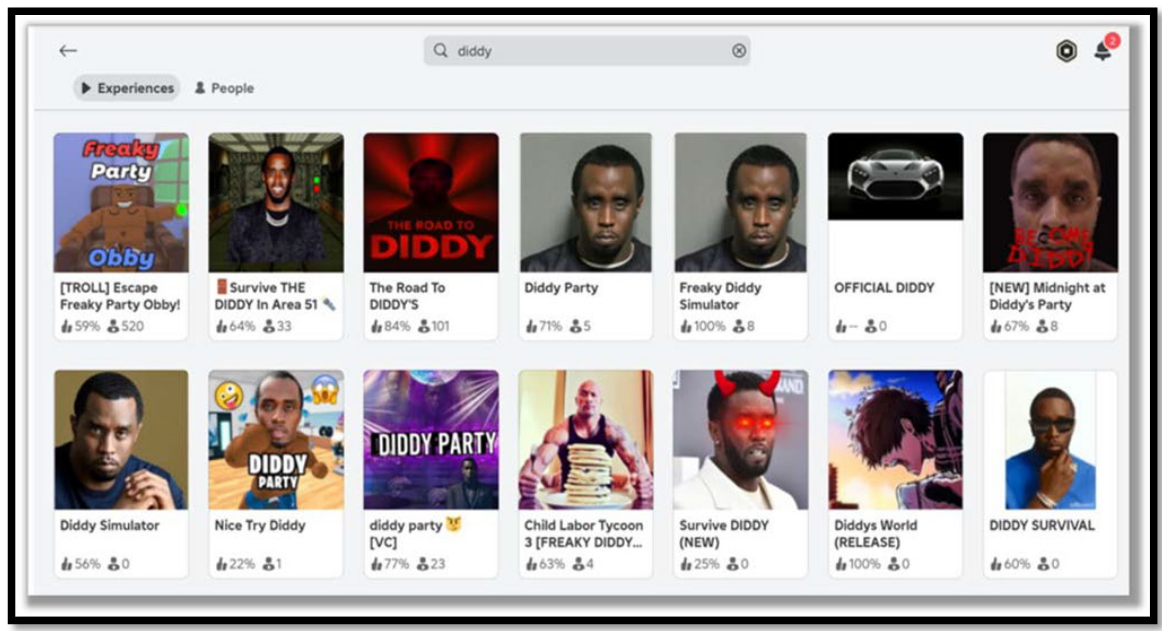

Tidal wave over Arecibo

Tidal waves are normally thought of as massive walls of ocean water, but the sky is also rippled by tides of solar energy generated by the Sun’s activity. This week, a team discovered a “strong and unusual” tidal wave that reverberated about 160 to 300 miles above Puerto Rico’s Arecibo telescope on the night of March 17, 2015.

“We found that this tide is surprisingly powerful, with wind speeds around 25 m/s—larger than those seen in more common tidal patterns,” said researchers led by Yun Gong of Wuhan University. “This is the first time such a strong 4.8-hour tide has been reported at these heights.”

The team noted that the wave was probably amplified by a geomagnetic storm, though the finer details of such complex interactions are still up in the air. The study is a testament to the ongoing afterlife of Arecibo, which sadly collapsed in 2020, but remains a legendary icon in part because of its extensive archives that date back to 1963.

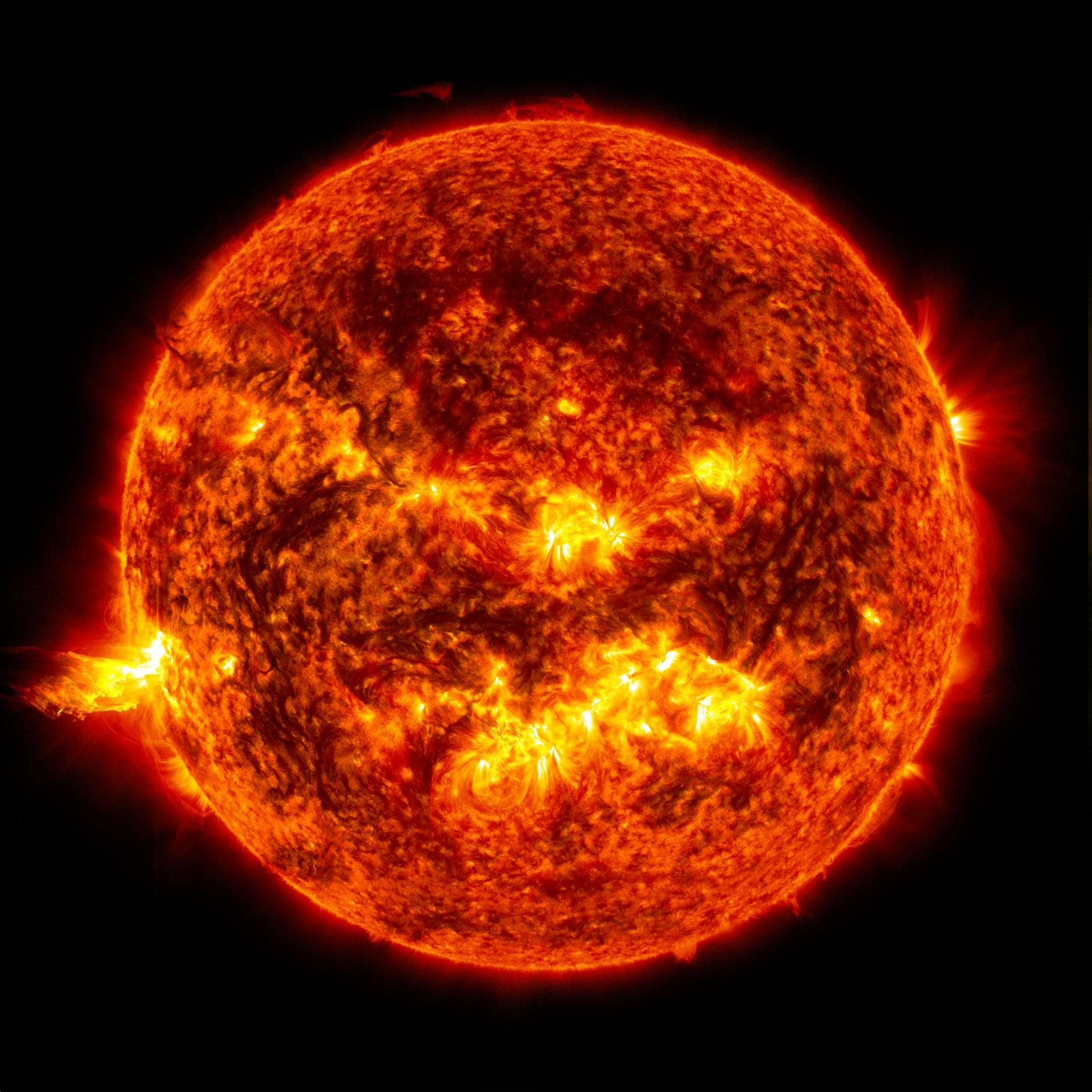

The floor is lava

Just in case you haven’t expressed gratitude to Earth lately, here’s a study about “lava planets,” which are rocky worlds that orbit so close to their stars that their day-sides reach 5,000°F.

Artist concept of a lava planet. Image: ESO/L. Calcada

“Unlike rocky planets in the solar system, lava planets maintain a long-lived, shallow magma ocean on their day-side, even after billions of years of interior cooling,” said researchers led by Charles-Édouard Boukaré of York University. “Such asymmetric magma oceans have no analogues in the solar system and their internal dynamics and evolution are still poorly understood.”

Fortunately, lava planets are a current priority for observation by the James Webb Space Telescope, so we may learn more about them soon. Even as we ride out more intense heat waves on Earth, pour a cold one out for these tortured worlds.

Moving day for mole rats

Burrowing animals are disproportionately threatened by the steady march of human land developments (citation: Watership Down). European blind mole rats, for instance, “have long been persecuted, and many species are threatened by extinction as they only exist in a few small and isolated populations,” according to a new study.

A model of a blind mole rat in Ukraine. Image: Максим Яковлєв

Though maligned in the past, these unique rodents are increasingly recognized as beneficial ecosystem engineers—plus, they are textbook “ugly-cute,” an aesthetic I cherish. To that end, the study followed up on translocation efforts that moved vulnerable colonies to new and safer sites.

“In the seven projects, a total of 141 blind mole rat individuals were translocated, of which 56 were males and 85 were females,” said researchers led by Orsolya Moldován of the University of Debrecen in Hungary. These “recent conservation efforts… were mostly successful and reversed the 200-year trend of decline. The method is thus promising for saving blind mole rats from extinction and for ensuring their long-term survival.”

It’s uplifting to know that there’s still a light at the end of the tunnel for these burrowing beauties.

The hottest summer look: Butt-grass

We’ll close with a recent study that I first saw reported by Sabrina Imbler of Defector about chimps that put grass in their buttholes as a style choice. I suggest you read their article through to the final reveal, which is surprisingly heart-warming for a tale of bum-grass. But for our purposes, here's the upshot:

After witnessing chimps at Zambia’s Chimfunshi sanctuary adorning their ears with grass, a team “observed the birth of a related variant in which chimpanzees started to wear the grass from their rectums,” a trend that spread “to most of the group within six weeks,” according to researchers led by Edwin J.C. van Leeuwen of Utrecht University in the Netherlands.

An analysis of the grass-wearing behaviors. Image: Van Leeuwen, Edwin J.C. et al.

“Though we primarily observed grass-in-rectum behavior by the same individual (the plausible innovator), the behavior was adopted by at least five other individuals from the same group, of whom two are still performing it to this day, almost a year after initial observations,” the team said.

It’s another reminder to be the plausible innovator you want to see in the world. You never know what hare-brained scheme (or grass-butted one) might catch on.

Thanks for reading! See you next week.

From 404 Media via this RSS feed

The front and back of the screen next to the Orange Drive building. Photo: 404 Media

The front and back of the screen next to the Orange Drive building. Photo: 404 Media

Image via 4chan, blurred by 404 Media.

Image via 4chan, blurred by 404 Media.

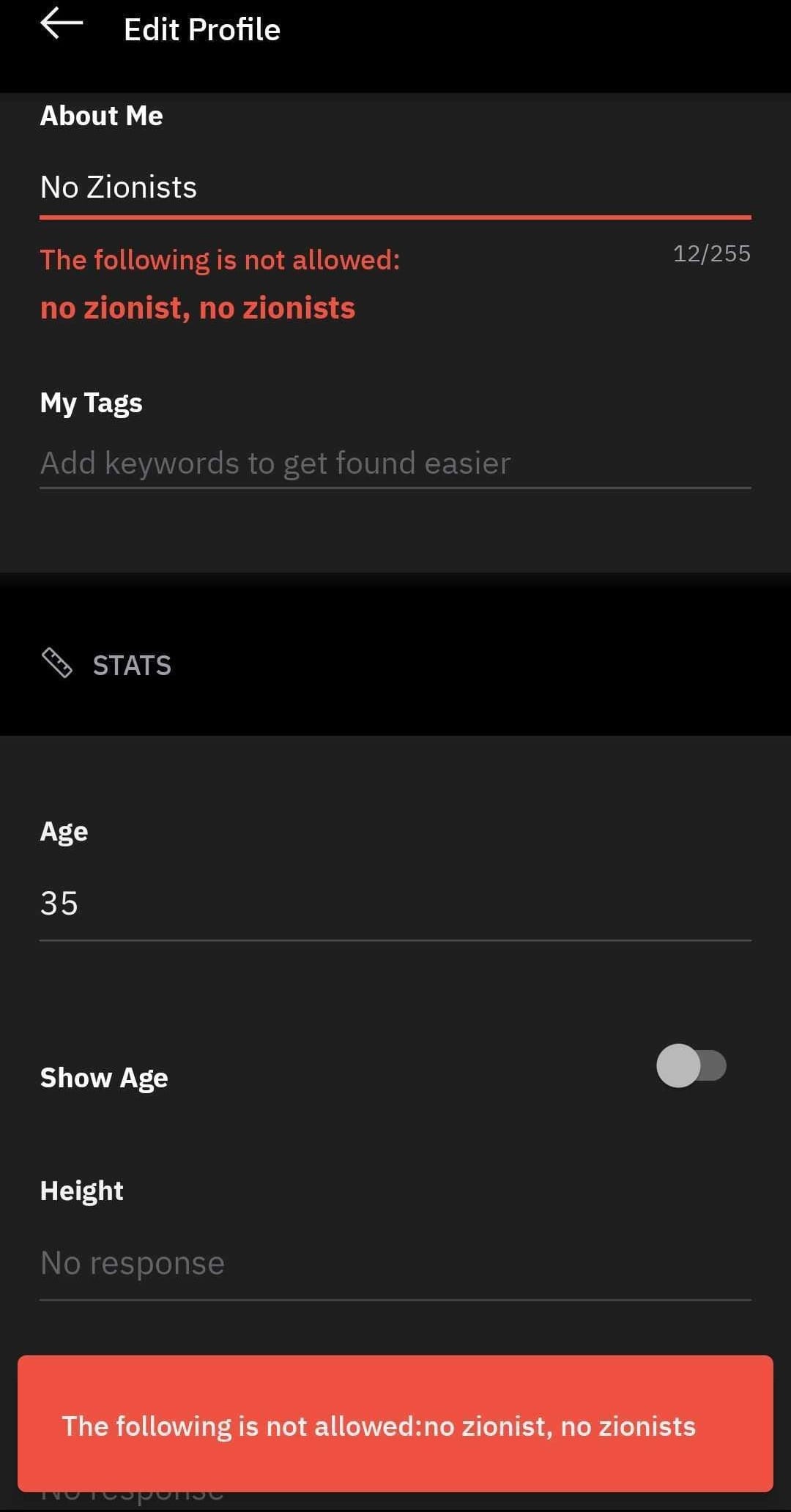

Screenshot from Grindr showing "the following is not allowed: no zionist, no zionists" error

Screenshot from Grindr showing "the following is not allowed: no zionist, no zionists" error